Après presque deux mois de préparation, je vous présente la nouvelle mise à jour du module « Assistants IA » pour Dolibarr. Cette version intègre d’importantes nouveautés qui élargissent considérablement ses capacités.

Nouveaux modèles intégrés

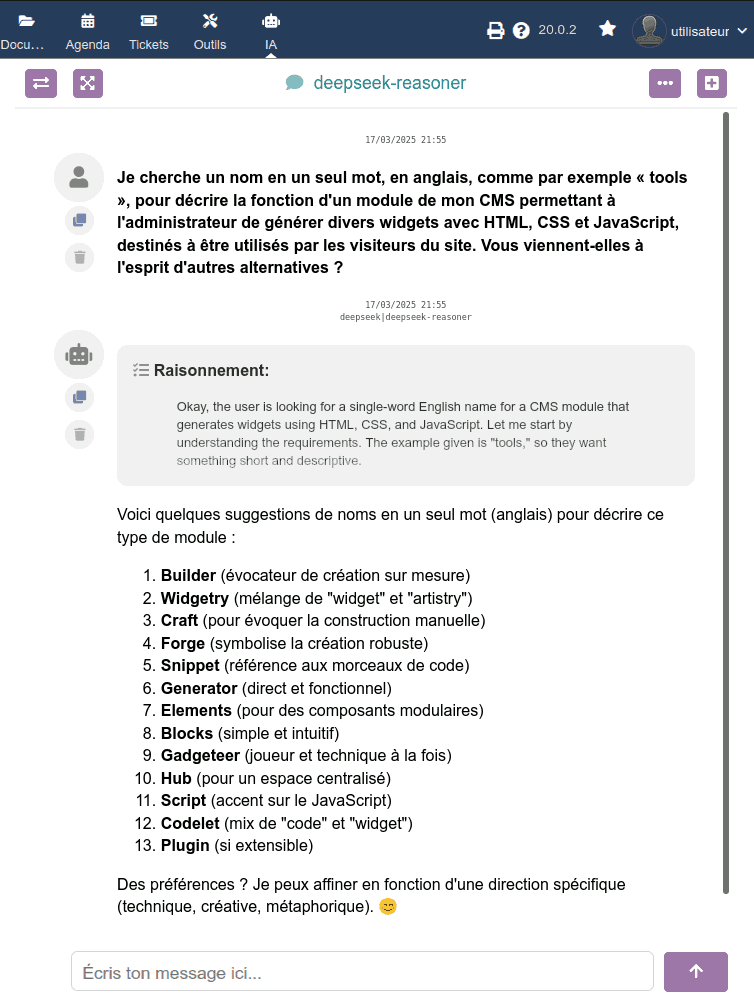

DeepSeek

Le modèle chinois disruptif DeepSeek a été toute une révélation :

- Extrêmement rapide

- Véritablement multilingue (même en catalan)

- Son modèle de raisonnement R1 montre de façon transparente la « chaîne de pensée » (CoT)

Mistral

J’ai également intégré l’API de Mistral, le prometteur LLM européen qui offre :

- Grande vitesse de réponse

- Prix très compétitifs

- Excellente performance dans les langues européennes

- Capacités de vision (analyse d’images) à des prix économiques

Mises à jour des fournisseurs existants

- OpenAI : Intégration des modèles de raisonnement économiques o1-mini et o3-mini

- Perplexity : Mise à jour vers la famille Sonar et Sonar-pro avec des variantes « Reasoning » et « DeepResearch »

Améliorations de l’interface

J’ai repensé le sélecteur de modèles, les regroupant en deux catégories :

- Conversation

- Génération d’images

Les modèles conversationnels incluent maintenant des icônes indiquant leurs capacités spéciales :

Vision

Vision Recherche web

Recherche web Raisonnement

Raisonnement

N’oubliez pas que vous pouvez changer de modèle à tout moment pendant une conversation pour optimiser les coûts.

Complexité dans la tarification des API

La tarification devient plus complexe en raison des diverses capacités :

Modèles avec vision

Ils facturent par cadres de NxN pixels dans les images analysées, et les prix varient même selon le modèle du même fournisseur.

Modèles de raisonnement

En plus des tokens d’ENTRÉE (prompt de l’utilisateur) et des tokens de réponse du modèle (SORTIE), ils facturent également les tokens générés pendant la chaîne de pensée.

Modèles de recherche web

Ils facturent pour :

- Tokens du prompt (ENTRÉE)

- Prix par millier de recherches

- Tokens des résultats de recherche (comme ENTRÉE)

- Tokens de la réponse finale (SORTIE)

Bien que les prix restent abordables, je recommande de surveiller la consommation, en particulier avec les fonctions de recherche et de raisonnement.

Prochain développement : connexion avec des modèles auto-hébergés

Plusieurs utilisateurs ont manifesté leur intérêt pour se connecter à des solutions comme Ollama ou LLM Studio pour exécuter leurs propres modèles. Je prévois de travailler sur un « connecteur générique » compatible avec la norme OpenAI au cours du mois prochain.

Seriez-vous intéressés par cette fonctionnalité ? Vos commentaires m’aideront à prioriser ce développement.

J’apprécie toute suggestion ou retour sur cette mise à jour